Eddigi ZH-kérdések

a (→Unix-alapok: typo) |

a (Volt, aki azt hitte, ennyi a tárgy anyaga, és meglepődött, amikor olyat is kérdeztem, ami itt nem szerepelt. :o) |

||

| (egy szerkesztő 12 közbeeső változata nincs mutatva) | |||

| 1. sor: | 1. sor: | ||

| − | Az alábbiakban leírom az eddig szerepelt zh-kérdéseket, a hozzájuk tartozó helyes válaszokat (ezeket a zh-ban elvárt minimális részletességnél szabatosabban kifejtve), és esetleg néhány, a hallgatók által írt választ, kommentárokkal. Az olvashatatlan szavakat "????" jelöli; a megtippelt, de nem jól olvasható szavakat "????megtippelt_szó????". A helyes válaszokban zárójelben szereplő mondatok csak kiegészítik a választ, nem elvárás, hogy a zh-ban is leírjátok őket. |

+ | Az alábbiakban leírom a 2009-ig szerepelt zh-kérdéseket (a frissebbek megtalálhatók az egyes szócikkek alatt), a hozzájuk tartozó helyes válaszokat (ezeket a zh-ban elvárt minimális részletességnél szabatosabban kifejtve), és esetleg néhány, a hallgatók által írt választ, kommentárokkal. Az olvashatatlan szavakat "????" jelöli; a megtippelt, de nem jól olvasható szavakat "????megtippelt_szó????". A helyes válaszokban zárójelben szereplő mondatok csak kiegészítik a választ, nem elvárás, hogy a zh-ban is leírjátok őket. |

A megadott pontszámok a zh-ban szereplő pontszámok; elvileg a kérdések relatív nehézségén és fontosságán kívül azt is hivatottak tükrözni, mennyire részletes választ várok el. A későbbiekben a tapasztalatok alapján ezek a pontszámok módosulhatnak, és egy itt leírt négypontos kérdés legközelebb szerepelhet pl. hatpontosként. |

A megadott pontszámok a zh-ban szereplő pontszámok; elvileg a kérdések relatív nehézségén és fontosságán kívül azt is hivatottak tükrözni, mennyire részletes választ várok el. A későbbiekben a tapasztalatok alapján ezek a pontszámok módosulhatnak, és egy itt leírt négypontos kérdés legközelebb szerepelhet pl. hatpontosként. |

||

Sajnos a zh-k helyesírása és magyarsága több esetben hagyott kívánnivalót maga után. Szerintem helytelenül írni igénytelenség. Ezzel persze nem kötelező egyetérteni, és a pontozásnál sem vettem figyelembe a nem értelemzavaró hibákat, de azért próbáljatok erre is odafigyelni. |

Sajnos a zh-k helyesírása és magyarsága több esetben hagyott kívánnivalót maga után. Szerintem helytelenül írni igénytelenség. Ezzel persze nem kötelező egyetérteni, és a pontozásnál sem vettem figyelembe a nem értelemzavaró hibákat, de azért próbáljatok erre is odafigyelni. |

||

| + | |||

| + | '''Figyelem!''' A félreértések elkerülése végett: ennek az oldalnak az elolvasása, esetleg bemagolása nem pótolja a segédanyag többi részének elolvasását és megértését. Sajnálatos, hogy erre külön fel kell hívni a figyelmet. |

||

== [[Unix-alapok]] == |

== [[Unix-alapok]] == |

||

| 296. sor: | 298. sor: | ||

: A HTTP virtualhosting működési elve az, hogy a HTTP ''Host:'' fejlécében megmondjuk a webszervernek, melyik virtuális szerver címterében kell értelmezni a kérésben átadott elérési utat és fájlnevet. Ha HTTPS-t használunk, akkor a böngésző és a webszerver közötti TCP-kapcsolat felépülése után először az SSL handshake-re kerül sor; ennek során a böngésző hitelesíti a szervert, és többek között azt is ellenőrzi, hogy a szerver tanúsítványa az URL-ben szereplő hosztnévre szól-e. |

: A HTTP virtualhosting működési elve az, hogy a HTTP ''Host:'' fejlécében megmondjuk a webszervernek, melyik virtuális szerver címterében kell értelmezni a kérésben átadott elérési utat és fájlnevet. Ha HTTPS-t használunk, akkor a böngésző és a webszerver közötti TCP-kapcsolat felépülése után először az SSL handshake-re kerül sor; ennek során a böngésző hitelesíti a szervert, és többek között azt is ellenőrzi, hogy a szerver tanúsítványa az URL-ben szereplő hosztnévre szól-e. |

||

: A gond az, hogy a szerver ebben a pillanatban még nem tudja, hogy mi az URL, így, ha virtuális hosztokat használunk, nem tudja eldönteni, melyik virtuális hoszt tanúsítványával hitelesítse magát a böngésző felé; ha nem a jót választja, a böngésző hibaüzenetet ad (vagy az alkalmazásszintű proxy megtagadja a webszájthoz való hozzáférést). A szerver csak az SSL-handshake után, a HTTP-tranzakcióból tudja meg (a ''Host:'' fejlécből), hogy melyik virtualhostra kíváncsi a kliens. |

: A gond az, hogy a szerver ebben a pillanatban még nem tudja, hogy mi az URL, így, ha virtuális hosztokat használunk, nem tudja eldönteni, melyik virtuális hoszt tanúsítványával hitelesítse magát a böngésző felé; ha nem a jót választja, a böngésző hibaüzenetet ad (vagy az alkalmazásszintű proxy megtagadja a webszájthoz való hozzáférést). A szerver csak az SSL-handshake után, a HTTP-tranzakcióból tudja meg (a ''Host:'' fejlécből), hogy melyik virtualhostra kíváncsi a kliens. |

||

| − | : Két megoldás van: az egyik az, hogy minden HTTPS-es virtualhostos külön IP:port páron futtatunk, így a szerver abból, hogy melyik IP:portra jött kapcsolatkérés, meg tudja állapítani, melyik virtualhostot szólítják meg éppen, és így azt is tudja, melyik tanúsítvánnyal kell hitelesítenie magát. |

+ | : Négy megoldás van: az egyik az, hogy minden HTTPS-es virtualhostot külön IP:port páron futtatunk, így a szerver abból, hogy melyik IP:portra jött kapcsolatkérés, meg tudja állapítani, melyik virtualhostot szólítják meg éppen, és így azt is tudja, melyik tanúsítvánnyal kell hitelesítenie magát. |

| − | : A másik megoldást csak akkor használhatjuk, ha minden virtualhostunk ugyanabba a domainbe tartozik, és a hitelesítő hatóságunk (CA, certificate authority) hajlandó nekünk joker-tanúsítványt adni erre a domainre; ekkor a tanúsítvány elvileg minden, az adott domainbe tartozó konkrét hosztnévre érvényes lesz, tehát a szerver nem kerül olyan dilemma elé, hogy több tanúsítvány közül kellene választania, vagyis az összes virtualhost maradhat ugyanazon az IP:port páron, hanem hitelesítheti magát azzal az eggyel, ami van. A módszer hátránya, hogy nem minden CA ad ki - és nem minden böngésző fogadja el - a joker-tanúsítványt. |

+ | : A második megoldást csak akkor használhatjuk, ha minden virtualhostunk ugyanabba a domainbe tartozik, és a hitelesítő hatóságunk (CA, certificate authority) hajlandó nekünk joker-tanúsítványt (wildcard cert) adni erre a domainre; ekkor a tanúsítvány elvileg minden, az adott domainbe tartozó konkrét hosztnévre érvényes lesz, tehát a szerver nem kerül olyan dilemma elé, hogy több tanúsítvány közül kellene választania, vagyis az összes virtualhost maradhat ugyanazon az IP:port páron, hanem hitelesítheti magát azzal az eggyel, ami van. A módszer hátránya, hogy nem minden CA ad ki joker-tanúsítványt, és elképzelhető, hogy nem minden böngésző fogadja el. |

| + | : A harmadik megoldás az SNI, aminek az a lényege, hogy a kliens még az SSL handshake előtt jelzi a szervernek, milyen névre szóló tanúsítványt vár. |

||

| + | : A negyedik megoldás az, hogy a tanúsítványban a Subject Alternative Name mezőben felsoroljuk az összes virtualhost nevét (a felsorolás tartalmazhat jokereket is). |

||

: '''Egy válasz a zh-ból (betű szerint):''' |

: '''Egy válasz a zh-ból (betű szerint):''' |

||

| 303. sor: | 305. sor: | ||

: ''1. különböző portra kell tenni a virtuális HTTPS-szervereket és port alapján tudjuk, melyik cert. kell'' |

: ''1. különböző portra kell tenni a virtuális HTTPS-szervereket és port alapján tudjuk, melyik cert. kell'' |

||

: ''2. a domain-re vonatkozó cert. kell'' |

: ''2. a domain-re vonatkozó cert. kell'' |

||

| − | : '''Kommentár:''' A válasz 5 pontot ér. Fél pont levonás jár azért, mert nem fejti ki, mi "a domain" (impliciten feltételezi, hogy minden virtualhost ugyanabba a domainbe tartozik), és másik fél pont levonás azért, mert nemcsak külön portra, hanem külön IP-re is tehetjük az egyes virtuális szervereket; az IP:port ''párnak'' kell különböznie. |

+ | : '''Kommentár:''' A válasz 3 pontot ér. Fél pont levonás jár azért, mert nem fejti ki, mi "a domain" (impliciten feltételezi, hogy minden virtualhost ugyanabba a domainbe tartozik), és másik fél pont levonás azért, mert nemcsak külön portra, hanem külön IP-re is tehetjük az egyes virtuális szervereket; az IP:port ''párnak'' kell különböznie. Két pont levonás jár az SNI kihagyásáért. |

== [[Filerendszerek]] == |

== [[Filerendszerek]] == |

||

| 423. sor: | 425. sor: | ||

: ''Fontos még a naplózás is. ext3 fizikai naplót vezet. Az xfs pedig logikai naplót. Ez utóbbi fontos előnye hogy csak a metaadatokat írja a log file-ba, ezáltal gyorsabban ????visszaállítható????, mint pl. az ext3.'' |

: ''Fontos még a naplózás is. ext3 fizikai naplót vezet. Az xfs pedig logikai naplót. Ez utóbbi fontos előnye hogy csak a metaadatokat írja a log file-ba, ezáltal gyorsabban ????visszaállítható????, mint pl. az ext3.'' |

||

: ''Ha nem linuxban gondolkodunk jó megoldás pl a SUN-os zfs ahol a logikai kötetek és a filerendszer "összenőtt". Az átméretezés online így nem gond. (plane hogy a használt ufs fs már régóta tudja ezt)'' |

: ''Ha nem linuxban gondolkodunk jó megoldás pl a SUN-os zfs ahol a logikai kötetek és a filerendszer "összenőtt". Az átméretezés online így nem gond. (plane hogy a használt ufs fs már régóta tudja ezt)'' |

||

| − | : '''Kommentár:''' A válasz 4 pontot ér. Egyrészt nem említi a snapshot-támogatást, másrészt az LVM pont a fizikai kötetek méretét nem tudja megváltoztatni. A logikai és a fizikai napló nem abban különbözik, hogy csak a meta-adatokat naplózza, vagy az összeset, hanem abban, hogy milyen módon teszi ezt. A fizikai naplóban a diszkre kiírandó szektorok vannak benne, egy az egyben, míg a logikai naplóban az elvégzendő módosítások magas szintű leírása, ami sokkal kompaktabb. |

+ | : '''Kommentár:''' A válasz 4 pontot ér. Egyrészt nem említi a snapshot-támogatást, másrészt az LVM pont a fizikai kötetek méretét nem tudja megváltoztatni (megj.: ez azóta változott, most már van <tt>pvresize</tt> is). A logikai és a fizikai napló nem abban különbözik, hogy csak a meta-adatokat naplózza, vagy az összeset, hanem abban, hogy milyen módon teszi ezt. A fizikai naplóban a diszkre kiírandó szektorok vannak benne, egy az egyben, míg a logikai naplóban az elvégzendő módosítások magas szintű leírása, ami sokkal kompaktabb. |

== [[A bootfolyamat]] == |

== [[A bootfolyamat]] == |

||

| 573. sor: | 575. sor: | ||

: '''Helyes válasz:''' |

: '''Helyes válasz:''' |

||

: Mivel a TCP kapcsolatorientált, a naplózószerver elvileg túlterhelhető kapcsolatokkal. |

: Mivel a TCP kapcsolatorientált, a naplózószerver elvileg túlterhelhető kapcsolatokkal. |

||

| − | : Mivel a TCP-ben van torlódásvezérlés, elképzelhető, hogy a naplóüzeneteket író programok blokkolódnak arra várva, hogy a helyi üzenetpuffert hálózaton át üríteni lehessen; ha nem ezt várják meg, egy idő után megtelik a memória a pufferrel vagy elküldés nélkül el kell dobni üzeneteket. |

+ | : Mivel a TCP-ben van torlódásvezérlés, elképzelhető, hogy a naplóüzeneteket író programok blokkolódnak arra várva, hogy a helyi üzenetpuffert hálózaton át üríteni lehessen; ha ezt nem várják meg, egy idő után megtelik a memória a pufferrel vagy elküldés nélkül el kell dobni üzeneteket. |

: A TCP-kapcsolatok szemantikájának megvalósítása növeli a naplózókliens összetettségét; kezelni kell pl., ha megszakad a hálózati kapcsolat. |

: A TCP-kapcsolatok szemantikájának megvalósítása növeli a naplózókliens összetettségét; kezelni kell pl., ha megszakad a hálózati kapcsolat. |

||

: Az UDP kapcsolatmentes, "fire and forget" jellegű. Emiatt kliensoldalon nem feltétlenül van visszajelzés arról, hogy egy üzenet elküldése sikeres volt-e, vagyis hálózati problémák esetén naplóüzenetek elveszhetnek útközben. |

: Az UDP kapcsolatmentes, "fire and forget" jellegű. Emiatt kliensoldalon nem feltétlenül van visszajelzés arról, hogy egy üzenet elküldése sikeres volt-e, vagyis hálózati problémák esetén naplóüzenetek elveszhetnek útközben. |

||

| 697. sor: | 699. sor: | ||

== Gyakorlati rész == |

== Gyakorlati rész == |

||

| + | |||

| + | === Routingos feladat 2006. === |

||

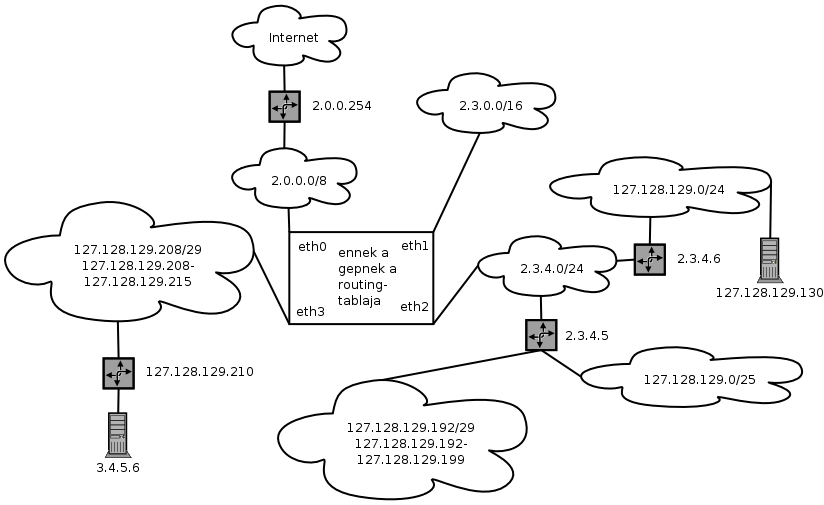

* Adott a következő routing-tábla, és a 127.128.129.130-as géppel szeretnénk kommunikálni. A tábla mely sorai milyen sorrendben jutnak szerephez? Milyen üzeneteket kell kiküldenünk, ha feltételezzük, hogy az ARP-táblánk üres? Töltse ki a táblázat üresen hagyott mezőit (a megadott adatokból a hiányzó adatok kikövetkeztethetők)! Rajzolja le a routing-tábla által leírt hálózat topológiáját! (20 pont) |

* Adott a következő routing-tábla, és a 127.128.129.130-as géppel szeretnénk kommunikálni. A tábla mely sorai milyen sorrendben jutnak szerephez? Milyen üzeneteket kell kiküldenünk, ha feltételezzük, hogy az ARP-táblánk üres? Töltse ki a táblázat üresen hagyott mezőit (a megadott adatokból a hiányzó adatok kikövetkeztethetők)! Rajzolja le a routing-tábla által leírt hálózat topológiáját! (20 pont) |

||

| 780. sor: | 784. sor: | ||

Azzal nem kell törődni, hogy bizonyos állomások látszólag több helyen is vannak; a routing mindenképpen a legspecifikusabb route-ot választja. |

Azzal nem kell törődni, hogy bizonyos állomások látszólag több helyen is vannak; a routing mindenképpen a legspecifikusabb route-ot választja. |

||

| − | ---- |

+ | === Scriptes feladat 2006. === |

* Keressen versenyhelyzeteket, logikai vagy biztonsági hibákat az alábbi scriptben! Hogyen lehetne ezeket elkerülni? Amúgy mit próbál csinálni a script? (20 pont) |

* Keressen versenyhelyzeteket, logikai vagy biztonsági hibákat az alábbi scriptben! Hogyen lehetne ezeket elkerülni? Amúgy mit próbál csinálni a script? (20 pont) |

||

| 828. sor: | 832. sor: | ||

# További probléma a 16. sorral, hogy itt is lőhetünk ki ártatlan processzt, pl. ha a mi tailünk bármi (mondjuk I/O error) miatt kilépett, és az ő PID-jával indult valami más, akkor ezt a mást lőjük ki még akkor is, ha a 10 sorban a mi tailünk PID-ja (és csak az) került a TAILPID változóba. |

# További probléma a 16. sorral, hogy itt is lőhetünk ki ártatlan processzt, pl. ha a mi tailünk bármi (mondjuk I/O error) miatt kilépett, és az ő PID-jával indult valami más, akkor ezt a mást lőjük ki még akkor is, ha a 10 sorban a mi tailünk PID-ja (és csak az) került a TAILPID változóba. |

||

| − | ---- |

+ | === Scriptes feladat 2007. === |

| + | |||

| + | Keressen versenyhelyzeteket, logikai vagy biztonsági hibákat az alábbi scriptben! Melyiknek mi a (nem kívánt) hatása? Melyik mennyire súlyos, ha a scriptet a rendszergazda futtatja? És ha egy normális felhasználó? Hogyan lehetne ezeket a hibákat elkerülni? Amúgy mit próbál csinálni a script? (20 pont) |

||

| + | |||

| + | <pre> |

||

| + | 1. #!/bin/sh |

||

| + | 2. # redirect stdout to log |

||

| + | 3. exec >foobar.$$.log |

||

| + | 4. # copy log to stderr |

||

| + | 5. tail -f foobar.$$.log >&2 & |

||

| + | 6. pidof tail >/tmp/tail.pid |

||

| + | 7. mkdir $(date) |

||

| + | 8. for i in $(find $@ -name *.mp3); do ln $i $(date)/; done |

||

| + | 9. touch $(date)/* |

||

| + | 10. find / -name *.mp3 >/tmp/mp3.log & |

||

| + | 11. FINDPID1=$(pidof find) |

||

| + | 12. find . –atime +30d | xargs echo rm –rf 2>/tmp/delete.log >/tmp/deleteold.sh & |

||

| + | 13. FINDPID2=$(pidof find) |

||

| + | 14. echo "Operation in progress... please wait." |

||

| + | 15. sleep 5 |

||

| + | 16. cd $(date) |

||

| + | 17. echo Start: |

||

| + | 18. ls |

||

| + | 19. for i in *; do |

||

| + | 20. mv $i $(echo $i | sed 's/.*-/$ARTIST-/') |

||

| + | 21. done |

||

| + | 22. echo End: |

||

| + | 23. ls |

||

| + | 24. echo Waiting for find to exit. |

||

| + | 25. for i in $FINDPID1 $FINDPID2; do |

||

| + | 26. while [ -d /proc/$i ]; do |

||

| + | 27. echo Waiting... |

||

| + | 28. sleep 5 |

||

| + | 29. done |

||

| + | 30. done |

||

| + | 31. # don't need this anymore, clean it up |

||

| + | 32. kill $(cat /tmp/tail.pid) |

||

| + | 33. rm –rf /tmp/tail.pid |

||

| + | </pre> |

||

| + | |||

| + | Erről a feladatról rengeteget lehet írni, mert nagyon sok a hiba a scriptben. A 20 pontért nem kellett mindet megtalálni. |

||

| + | |||

| + | Hibák (az abszolút teljesség igénye nélkül): |

||

| + | |||

| + | # A 3. sorban megjósolható nevű ideiglenes fájlt hozunk létre; ha a scriptet egy támadó számára is írható könyvtárban futtatjuk, a támadó előre elhelyezhet <tt>foobar.{2-32767}.log</tt> nevű, valamilyen számára nem írható fájlra mutató symlinkeket ebben a könyvtárban; a script indításakor a kérdéses fájl a futtató felhasználó jogait használva íródik felül. Ha a scriptet a rendszergazda futtatja, szinte bármelyik fájl felülírható. A hibát úgy lehetett volna elkerülni, ha egyrészt nem abban a könyvtárban hozzuk létre az ideiglenes fájlt, amelyben éppen vagyunk (és amelyről nem tudunk semmit), hanem egy csak számunkra írható, konkrétan megadott könyvtárban; másrészt pedig ha a - például az <tt>mktemp(1)</tt> segítségével - biztonságos módon, mindenképpen egyedi néven hozzuk létre a fájlt. |

||

| + | # A 3. sorban megkísérlünk létrehozni egy fájlt, ám nincs hibakezelés; egyszerűen feltételezzük, hogy sikerült, és az 5. sorban megpróbálunk olvasni a fájlból. Ha egy támadó olyan fájlra mutató symlinket helyezett el a mi fájlunk helyén, amelyet írni nem tudunk, csak olvasni, akkor a 3. sor nem írta felül, az 5. sor viszont kiírja az utolsó tíz sort és a később keletkezőket a képernyőre. Ha a fájl érzékeny adatokat tartlamaz, akkor ez nem kívánatos. A jó megoldás ugyanaz, mint az előbb. (Hasonló, de nehezebben kivitelezhető támadás, ha az aktuális könyvtár nem sticky és a támadónak is van rá írási joga: a támadó a 3. sor végrehajtása után, de az 5. végrehajtása előtt az érzékeny adatokat tartalmazó fájlra mutató symlinkkel helyettesíti a 3. sorban létrehozott fájlt. Így az sem akadály, ha a scriptet futtató usernek van rá írási joga; nem fog felülíródni, csak kilistázódni.) |

||

| + | # A 6. sorban lekérdezzük azoknak a processzeknek a PID-ját, amelyeknek a neve <tt>tail</tt>, és az eredményt egy megjósolható nevű, mindenki által írható könyvtárban található fájlba írjuk. Ugyanazok a megfontolások érvényesek, mint a harmadik sornál. |

||

| + | # A 6. sorban található <tt>pidof</tt> találhat nulla, egy vagy több futó <tt>tail</tt> nevű processzt; a script később (a 32. sorban) feltételezi, hogy egy volt, mégpedig az, amit az 5. sorban indítottunk. Ez több okból sem biztos. Egyrészt, az 5. és a 6. sor között versenyhelyzet van, mivel az 5. sort a háttérben indítjuk ("&" van a végén); elképzelhető, hogy amíg a háttérben indított shell a <tt>tail</tt>-t próbálja <tt>exec()</tt>-elni, addig nekünk lefut a 6. sorunk, és így még nincs is meg az <tt>tail</tt>, amit az 5. sorban indítottunk. Az is lehet, hogy mire a 6. sor lefut, az 5. sorban indított <tt>tail</tt> már kilépett (pl. mert a 3. sorban nem sikerült létrehozni a fájlt, mert nincs írási jogunk az aktuális könyvtárra, így az 5. sornál nem is létezik a fájl, vagyis a <tt>tail</tt> hibaüzenetet ad és "azonnal" kilép), és egy a rendszerben valaki más által futtatott <tt>tail</tt> nevű folyamatot találunk (vagyis még az sem garancia arra, hogy jó PID-t tárolunk, ha csak egy <tt>tail</tt> nevű folyamatot talál a <tt>pidof</tt>). |

||

| + | # A 7. sorban a <tt>date</tt> kimenetét közvetlenül átadjuk az mkdirnek, idézőjel nélkül. A <tt>date</tt> kimenete viszont a területi beállításoktól függően mindenféle karaktert tartalmazhat: szóközt, / karaktert stb. Ha szóközt tartalmaz, és a /bin/sh nem a zsh, akkor az mkdir minden bizonnyal több argumentumot fog látni, vagyis több alkönyvtárat hoz létre; ha /-t, akkor pedig egy könyvtár-részfát próbál létrehozni, de hacsak nem létezik az összes könyvtár az utolsót leszámítva, a -p kapcsoló nélkül hibát ad. Az lett volna a helyes, ha a date-nek előírjuk, hogy milyen formátumban szeretnénk a dátumot (pl. <tt>date +%Y%m%d</tt>). |

||

| + | # A 8. sor egy ciklus: <tt>for i in $(find $@ -name *.mp3); do ln $i $(date)/; done</tt>. Több gond is van vele. |

||

| + | #* Egyrészt, ha az argumentumlistánk szóközöket is tartalmazó könyvtárneveket is tartalmazott, akkor a <tt>find</tt> ezeket esetleg a szóközök mentén szétdarabolva kapja meg, vagyis nem mindegyikben fog keresni. |

||

| + | #* Másrészt, mivel a *.mp3-at nem tettük idézőjelbe, nem védtük meg a shelltől a csillagot, úgyhogy meg fogja próbálni az aktuális könyvtárban glob patternként értelmezni, vagyis behelyettesíteni a *.mp3 helyére az összes, az aktuális könyvtárban található .mp3 kiterjesztésű fájl nevét. |

||

| + | #** Ha nincs ilyen, akkor bizonyos shellek (pl. a zsh) hibaüzenetet adnak; mások (pl. a bash) meghagyják a parancssorban a *.mp3 sztringet betű szerint. |

||

| + | #** Ha pontosan egy .mp3 kiterjesztésű fájl van, akkor vele megegyező nevűeket keres a ciklus a megadott könyvtárak közül azokban, amelyeknek a nevében nem volt szóköz vagy egyéb szóhatároló karakter. |

||

| + | #** Ha egynél több .mp3 kiterjesztésű fájl van, a <tt>find</tt> nem tudja feldolgozni a parancssorát és hibaüzenetet ad. |

||

| + | #* Mindenesetre a ciklus csak abban az esetben keresi meg a megadott könyvtárakban található valamennyi mp3-at, ha az aktuális könyvtárban nincs mp3 kiterjesztésű fájl, a /bin/sh a bash, és a megadott könyvtárak nevében nincs szóhatároló karakter. |

||

| + | #* Ha a find kimenete szóhatárolót tartalmazó fájlneveket vagy könyvtárneveket is tartalmaz, a shell ezeket esetleg feldarabolja, mielőtt a ciklusváltozóval végigiterálna rajtuk. Így végül a ciklusváltozó nem a find által megtalált fájlok nevein megy végig, hanem azokon a szavakon, amelyekből ezek a nevek állnak. |

||

| + | #* A ciklusmagban minden iterációban újra lekérdezzük a dátumot, és feltételezzük, hogy az éppen lekérdezett dátumról elnevezett alkönyvtár létezik, és bele tudjuk hardlinkelni a megtalált fájlt. A dátum megváltozhatott azóta, hogy a könyvtárat létrehoztuk a 7. sorban (ha ugyan akkor sikerült egyáltalán létrehozni, ugye). A helyes megoldás az lett volna, hogy a dátumot egyszer kérdezzük le, egy változóban tároljuk, és mindig a változó értékét használjuk a $(date) helyett. |

||

| + | #* Az <tt>ln</tt> hardlinket hozna létre, de ez csak akkor lehetséges, ha a régi és az új fájlnév is ugyanazon a fájlrendszeren található; tehát a ciklus csak azokat a fájlokat fogja tudni odahardlinkelni a dátumról elnevezett, esetleg nem is létező könyvtárba, amelyek ugyanazon a fájlrendszeren vannak, mint ez a könyvtár. A többi fájl esetében hibaüzenetet kapunk (alighanem az "invalid cross-device link" szövegűt). |

||

| + | #* Több felsorolt könyvtárban is lehet azonos nevű mp3-fájl; ezeket mind ugyanabba a könyvtárba próbáljuk hardlinkelni (leszámítva a dátumváltozásokat :), így tehát fájlnév-ütközéskor nem jön létre a hardlink és hibaüzenetet kapunk. |

||

| + | # A 9. sorban megint gondjaink lesznek a szóhatároló karaktert tartalmazó fájlnevekkel, mert ezeket minden védelem nélkül adjuk át a touch-nak. zsh-ban ezt megtehetjük így (hogy glob expansion eredménye a szóközt tartalmazó fájlnév), de más shellben nem feltétlenül, úgyhogy oda kell rá figyelni. |

||

| + | # A 10. sorban korábbi hibák ismétlődnek: *.mp3, /tmp alatt létrehozott ismert nevű fájl stb. |

||

| + | # A 11. sor a 6. sor pepitában (nem biztos hogy pont annak a findnak a PID-ját találjuk meg, amit az előbb indítottunk stb.) |

||

| + | # A 12. sorban (<tt>find . –atime +30d | xargs echo rm –rf 2>/tmp/delete.log >/tmp/deleteold.sh &</tt>) elvileg a 30 napnál régebben megnyitott fájlokat keressük az aktuális munkakönyvtár alatt, és olyan parancssorokat építünk, amelyek ezeket a fájlokat letörlik. Itt is gond van a szóhatárolókat tartalmazó fájl- és könyvtárnevekkel; ezeknek a szavait egyenként fogjuk megpróbálni törölni. Két ismert nevű /tmp alatti fájlt is írunk, ami a korábban részletezett okok miatt veszélyes. |

||

| + | # A 13. sorban a script megint azt feltételezi, hogy csak az imént indított find PID-ját fogja megtalálni a pidof, pedig legalábbis a 10. sorban indított előző find is jó eséllyel fut még. |

||

| + | # A 14. és a 15. sorban nincs hiba(!) :). |

||

| + | # A 16. sorban az aktuális dátumról elnevezett könyvtárba próbálunk váltani, és itt is minden ezzel kapcsolatos eddig említett probléma érint minket (szóközök; változott a dátum a róla elnevezett könyvtár létrehozása óta; stb.). Nincs hibakezelés; ha itt nem sikerült könyvtárat váltani, a későbbi műveleteket akkor is végrehajtjuk, csak nem azokon a fájlokon, amiken szerettük volna. |

||

| + | # Nézzük a 19-21. sorban látható ciklust: <tt>for i in *; do mv $i $(echo $i | sed 's/.*-/$ARTIST-/'); done</tt>. |

||

| + | #* $i-re idézőjel nélkül hivatkozunk, így esetleg több szóra darabolódik. |

||

| + | #* A sed által előállított új fájlnév szintén tartalmazhat szóközt; azt is idézőjelbe kellett volna tenni. |

||

| + | #* $ARTIST sehol sem kapott értéket a scriptben; feltehetően a szülőfolyamattól kellene örökölni, de nem ellenőrizzük, hogy nem üres-e. |

||

| + | #* A sed-script aposztrófok között van, nem macskakörmök között, így $ARTIST értéke akkor sem helyettesítődik be, ha amúgy van neki; helyette szó szerint az fog szerepelni az új fájlnévben, hogy $ARTIST. |

||

| + | #* Ezzel a sed-scripttel több különböző fájlnevet is leképezhetünk ugyanarra a fájlnévre, vagyis az mv-vel kombinálva felülírhatunk fájlokat egymással. |

||

| + | # A 25-30. sorban levő ciklus arra próbál várni, hogy a findok kilépjenek. Gyakorlatilag mostanra simán elavulhattak azok a PID-k, amiket akkor találtunk, ha ugyan találtunk; úgyhogy ki tudja, hány és milyen processz kilépésére várunk, ráadásul sorban. Amíg arra várunk, hogy az első kilépjen, a többinek a PID-ja még akkor is érvénytelenné válhat (megkaphatja más processz), ha a külső ciklus elején még érvényes volt. Jó eséllyel lesznek olyan processzek, amelyeknek a kilépésére kétszer is várunk (mert mindkét változó tartalmazza a PID-jukat); ez tovább növeli annak az esélyét, hogy más processz kapja meg közben valamelyik PID-t, és esetleg sosem lép ki, vagyis az idők végezetéig csak várunk. Emellett persze nem biztos (csak nagyon valószínű), hogy be van mountolva a /proc fájlrendszer. |

||

| + | # A 32. sorban feltételezzük, hogy: |

||

| + | ## A <tt>/tmp/tail.pid</tt> fájl az, amit mi hoztunk létre; |

||

| + | ## hogy csak az általunk indított <tt>tail</tt> PID-ját tartalmazza, de azt igen; |

||

| + | ## hogy az általunk indított <tt>tail</tt> még mindig fut; |

||

| + | ## vagy ha esetleg nem futna, akkor a PID-ját még nem kapta meg más folyamat; |

||

| + | ## hogy a 6. sorban megtalált <tt>tail</tt> processzek közül egyikért sem kár; |

||

| + | ## hogy ezek a processzek sem léptek még ki; |

||

| + | ## vagy ha igen, akkor nem kapta meg más processz egyiknek a PID-ját sem; |

||

| + | ## vagy ha mégis, akkor ezekért az új processzekért, amelyek a hajdani <tt>tail</tt>-ek PID-jaival futnak, szintén nem kár. |

||

| + | # A 33. sorban, ha a /tmp/tail.pid egy könyvtár volt (ami már létezett, mielőtt mi megpróbáltunk ezen a néven fájlt létrehozni), akkor most a teljes tartalmával együtt letöröljük. |

||

| + | |||

| + | === Tűzfalas feladat 2006. === |

||

* Írjon iptables tűzfalscriptet. Topológia és követelmények: |

* Írjon iptables tűzfalscriptet. Topológia és követelmények: |

||

| 906. sor: | 910. sor: | ||

Általában célszerű arra törekedni, hogy egy tűzfalban az "amit nem szabad, azt tilos" elv jusson érvényre, nem pedig az "amit nem tilos, azt szabad"; a kettőt keverni pedig nagyon nem szerencsés (átláthatatlanná válik). |

Általában célszerű arra törekedni, hogy egy tűzfalban az "amit nem szabad, azt tilos" elv jusson érvényre, nem pedig az "amit nem tilos, azt szabad"; a kettőt keverni pedig nagyon nem szerencsés (átláthatatlanná válik). |

||

| + | |||

| + | === 2009/1. feladat === |

||

| + | |||

| + | Egy linuxos rendszeren a rendszergazda beállított ütemezett feladatként egy olyan shellscriptet, amely óránként lefut rendszergazdai jogkörrel, és a következő két sorból áll: |

||

| + | |||

| + | <pre> |

||

| + | #!/bin/bash |

||

| + | chmod 777 /tmp/* |

||

| + | </pre> |

||

| + | A <tt>/tmp</tt> könyvtár jogosultságbeállításai a szokásosak. Ha valamilyen nem-root felhasználóként be tudunk jelentkezni erre a rendszerre, hogyan tudunk a fentiek ismeretében rendszergazdai jogosultságokat szerezni (vagyis tetszőleges parancsot rootként lefuttatni)? Legalább két módszert találjon ki! (8 pont) |

||

| + | |||

| + | '''Megoldás:''' A chmod, ha nem mondunk neki mást, ész nélkül követi a symlinkeket és azon az inode-on állítja be a jogokat, amelyikre a symlink végeredményben mutat. A <tt>/tmp</tt> könyvtár mindenki számára írható, vagyis bárki bármilyen symlinket elhelyezhet itt. Az okos script gondoskodik arról, hogy a symlinkek célpontjai mindenki számára írhatóvá, olvashatóvá és végrehajthatóvá váljanak. |

||

| + | |||

| + | Ezután csak az a kérdés, mire mutasson az általunk létrehozott symlink. Nagyon sok jó megoldás van, ezért először kiemelnék két rosszat. Volt, aki úgy gondolta, hogy egy setuid root binárisra mutató symlinket hoz létre, amit majd felülír, ha megkapja rá a jogot, és utána a setuid bit miatt rendszergazdai jogosultságokkal futtatja. Ez azért nem működik, mert a <tt>chmod 777</tt> törli a setuid-bitet (ugye a jogosultságbitek igazából 4x3 bitből állnak, úgyhogy a 777 voltaképpen 0777-et jelent; az első 3 bit a setuid, a setgid és a sticky bit, amelyeket a 0777-es chmoddal nullázunk). |

||

| + | |||

| + | Egy másik rossz megoldás egy "<tt>foo; parancs;</tt>" nevű symlink létrehozása abban a reményben, hogy a shell, amikor a <tt>chmod 777 *</tt> parancssorát előállítja, a pontosvessző utáni részt új parancsként építi be a parancssorba. A shell ennyire szerencsére nem buta; a globbing nem parancssort, csak argumentumlistát állít elő. |

||

| + | |||

| + | Jó megoldások pl., a teljesség igénye nélkül: |

||

| + | |||

| + | * <tt>ln -s /etc/passwd /tmp</tt>, majd a saját userünk uid-ját átírjuk nullára; a legközelebbi belépésünkkor rendszergazdai jogaink lesznek. |

||

| + | * <tt>ln -s /etc/shadow /tmp</tt>, majd a root user jelszó-hash-ét átírjuk egy olyanra, amelyhez ismerjük a plaintextet. |

||

| + | * <tt>ln -s /az/adott/ütemezett/script /tmp</tt> (vagyis a fenti két sorból álló konkrét script); amikor írási jogot kapunk rá, hozzáfűzünk tetszőleges parancsokat a végéhez. |

||

| + | * <tt>ln -s /etc/crontab /tmp</tt>, és új ütemezett feladatot veszünk fel, amely rootként fut majd. |

||

| + | * <tt>ln -s /bin/bash /tmp</tt>; tudjuk, hogy a rendszergazdai jogokkal futó ütemezett script parancsértelmezője a bash, úgyhogy ha a basht felülírjuk, az általunk kívánt kód fog lefutni helyette, szintén rootként. |

||

| + | * <tt>ln -s /dev/sda /tmp</tt>; ezután megkerssük az sda-n található fájlrendszerben egy saját binárisunk inode-ját, átállítjuk a tulajdonosát rootra, majd beállítjuk rajta a setuid bitet is. |

||

| + | * <tt>ln -s /lib/libc.so.6 /tmp</tt>; majd a libc-t felülírva majdnem minden program a mi kódunkat is tartalmazni fogja, hiszen betöltik a libc6-ot. |

||

| + | * <tt>ln -s /etc /tmp</tt>; így az összes konfigurációs fájlt törölhetjük, majd sajátot hozhatunk létre a helyén, tetszőleges tartalommal. Ez a fenti támadások egy részének az általánosítása. |

||

| + | * <tt>ln -s / /tmp/gyökér</tt>; így végeredményben minden könyvtárat és fájlt helyettesíthetünk sajáttal, mert a gyökérkönyvtár összes elemét jogunk van átnevezni (a mountpointokat kivéve), és az eredeti néven saját fájlt vagy könyvtárat elhelyezni ott. Ez egy további általánosítás. |

||

| + | |||

| + | Sok-sok jó megoldás van még. Ezek közül kellett legalább kettőt leírni a maximális pontszámért. |

||

| + | |||

| + | === 2009/2. feladat === |

||

| + | |||

| + | Egy kollégánk több szerveren szeretne egymás után bizonyos parancsokat lefuttatni. A parancsokat minden szerveren elhelyezte a <tt>/root/bin/somescript</tt> nevű fájlban. A szerverek nevét a <tt>servers.txt</tt> fájl tartalmazza, soronként egyet. Kollégánk a következő egysoros scriptet írta a feladat megoldására: |

||

| + | <pre> |

||

| + | while read server; do ssh $server /root/bin/somescript; done <servers.txt |

||

| + | </pre> |

||

| + | Meglepve tapasztalja, hogy annak ellenére, hogy a <tt>servers.txt</tt> fájl számos sorból áll, a <tt>/root/bin/somescript</tt> csak az első szerveren hajtódik végre, a többin nem. A szerverek minden lényeges szempontból teljesen megegyeznek egymással. Ha a listán egy másikat rak az első helyre, akkor csak azon hajtódik végre a <tt>/root/bin/somescript</tt>. Mi lehet a probléma oka? (4 pont) |

||

| + | |||

| + | Segítségképpen felírtam a táblára, hogy a következő parancssor működik, és azt csinálja, amit gondolunk: |

||

| + | |||

| + | <pre> |

||

| + | echo foo | ssh user@bar cat \>baz |

||

| + | </pre> |

||

| + | |||

| + | '''Megoldás:''' itt arra kellett rájönni, hogy az ssh a kliensprogram standard inputját elérhetővé teszi a szerveren az ssh sessionön át elindított program számára. Azt kellett még végiggondolni, mi történik a fájldeszkriptorokkal az egysoros script végrehajtása során: |

||

| + | |||

| + | # A shell indít egy gyermekfolyamatot. |

||

| + | # Ez a gyermekfolyamat lezárja a standard inputját, majd megnyitja helyette a <tt>servers.txt</tt>-t (tehát minden input ebből a fájlból jön majd a továbbiakban). |

||

| + | # A gyermekfolyamat megkezdi az egysoros script feldolgozását. Lefut a <tt>read</tt> parancs, amely az input első sorát beolvassa a <tt>$server</tt> változóba. |

||

| + | # Az stdin fájldeszkriptorban ekkor az offszet (vagyis a következő olvasás pozíciójára mutató "pointer") a <tt>servers.txt</tt> fájl második sorának elejére mutat. |

||

| + | # Elindul az első <tt>ssh</tt> processz, amelynek az összes fájldeszkriptort, így az stdin-t is, örökli az őt indító shelltől. Vagyis az ő stdin-je is a <tt>servers.txt</tt> fájl, és az offszet továbbra is a második sor eleje. |

||

| + | # Felépül az ssh-kapcsolat, és a szerveren elindul a <tt>/root/bin/somescript</tt>, amely az <tt>sshd</tt>-től örökli az stdin FD-t. Az <tt>sshd</tt> (az ssh-szerverprogram) úgy indítja el a <tt>somescriptet</tt>, hogy egy-egy olyan pipe-ot örököl stdin-ként, stdout-ként és stderr-ként, amelyeknek a másik vége az <tt>sshd</tt> processzé, és a titkosított hálózati kapcsolaton keresztül az <tt>ssh</tt> kliensprogrammal van összekapcsolva. Tehát amit az ssh-szerveren futó program kiír, azt az ssh-kliens megkapja és kiírja a helyi konzolon, és fordítva, amit a szerveren futó program olvas, azt az ssh-kliens standard inputjáról olvassa (ezt tette egyértelművé a táblára felírt segítség). |

||

| + | # Ha minden a terv szerint menne, a <tt>somescript</tt> kilépne, erre az <tt>ssh</tt> is kilépne, a <tt>read</tt> beolvasná a következő sort, és mennénk tovább a következő szerverre. |

||

| + | |||

| + | Ehelyett azonban az történik, hogy a <tt>read</tt> a második alkalommal már nem olvas semmit, és emiatt sikertelen visszatérési értékkel tér vissza; emiatt pedig véget ér a <tt>while</tt>-ciklus (mert a ciklusban maradás feltétele az, hogy a <tt>read</tt> sikerüljön). Ezzel az egysoros scriptnek is vége. |

||

| + | |||

| + | Ha az lenne a baj, hogy nem érjük el a további szervereket, akkor az ssh hibaüzenetet adna és sokáig kellene várnunk, amíg próbál kapcsolódni. Ez aligha lepné meg annyira a kollégát, hogy tanácsot kellene kérnie tőlünk, és fontos körülményként biztosan megemlítené, ha mégis így lenne. Arra sem ad magyarázatot ez az elmélet, miért mindig a lista legelső elemén fut le a script, a többin sosem. |

||

| + | |||

| + | A valódi magyarázat az, hogy a <tt>somescript</tt> tartalmaz valami olyat, ami végigolvassa a standard inputot. Ezt az ssh-kapcsolaton keresztül megteheti; végeredményben elolvassa a <tt>servers.txt</tt> további sorait a későbbi <tt>read</tt> parancsok elől. Nem azért, mert ugyanabból a fájlból olvasnak (természetesen megnyithatja két egymástól független processz ugyanazt a fájlt és mindketten végigolvashatják), hanem azért, mert ugyanazon a fájldeszkriptoron keresztül olvassák a fájlt, így az offszet-mezőn is osztoznak. |

||

| + | |||

| + | Erre csak két hallgató jött rá; ők 4-4 pontot kaptak. Részpontszámot lehetett kapni olyan elméletekért, amelyek viszonylag plauzibilisek voltak, de a valóságban nem pont a leírt (és elmondott) viselkedést eredményezték volna. Nem zárom ki, hogy létezik az itt helyesként bemutatottól eltérő másik helyes válasz is, de a ZH-ban senki nem írt ilyet. |

||

| + | |||

| + | === 2009/3. feladat === |

||

| + | |||

| + | Legalább hány 1TB kapacitású diszkre van szükségünk ahhoz, hogy olyan [[Software RAID Linux alatt|linuxos soft-RAID-tömböt]] szervezzünk belőlük, amely legalább 2TB nettó kapacitással rendelkezik, bármely két diszk kiesését az esetleges bithibáktól eltekintve biztosan túléli, hozzáadható egy diszk melegtartalékként és van esély arra, hogy egy harmadik diszk kiesését is túlélje? Hogyan szerveződjön a [[RAID|tömb]]? Ha több minimális számú diszket igénylő értelmes megoldás is van, mindegyiket írja le! (8 pont) |

||

| + | |||

| + | '''Megoldás:''' először gondoljuk végig, hány diszk kell mindenképpen. 1, 2 és 3 triviálisan kevés, hiszen nem élheti túl három diszk kiesését. Négy szintén kevés, mert három kiesése esetén csak egy maradna, azon pedig nem fér el a kívánt 2TB nettó kapacitás. Tehát biztosan kell legalább öt diszk. Kérdés, elég-e öt? |

||

| + | |||

| + | Igen, elég. Több jó megoldás is van (az ezekkel izomorf megoldásokat nem tekintjük különbözőnek): |

||

| + | |||

| + | * raid5(raid1(sda, sdb), raid1(sdc, sdd), sde) (erre volt, aki rájött) |

||

| + | * raid6(sda, sdb, sdc, raid1(sdd, sde)) (erre is volt, aki rájött) |

||

| + | * raid4(raid1(sda, sdb), raid1(sdc, sdd), sde) (az sde a paritásdiszk; erre is volt, aki rájött) (ugyanez működhetne raid4 helyett raid3-mal is) |

||

| + | * Daraboljuk fel mind az öt diszket 2-2 500G-s partícióra, majd: raid5(raid1(sda1, sde2), raid1(sdb1, sda2), raid1(sdc1, sdb2), raid1(sdd1, sdc2), raid1(sde1, sdd2)) – így homogén tömböt kapunk, ami ráadásul garantáltan túléli három diszk kiesését. Erre nem jött rá senki. |

||

| + | |||

| + | Hat diszk evidens, hogy elég; nagyon sok jó megoldás van hat diszkkel (pl. RAID10, mindenből három példányt tárolva). Aki szerint hatnál több diszk a minimum, nem kapott sok pontot. |

||

| + | |||

| + | Aki a fenti jó megoldások közül legalább kettőt megemlített (és a leírás nem tartalmazott súlyos hibát), a nyolcból legalább hét pontot megkapott. |

||

A lap jelenlegi, 2012. december 12., 21:33-kori változata

Az alábbiakban leírom a 2009-ig szerepelt zh-kérdéseket (a frissebbek megtalálhatók az egyes szócikkek alatt), a hozzájuk tartozó helyes válaszokat (ezeket a zh-ban elvárt minimális részletességnél szabatosabban kifejtve), és esetleg néhány, a hallgatók által írt választ, kommentárokkal. Az olvashatatlan szavakat "????" jelöli; a megtippelt, de nem jól olvasható szavakat "????megtippelt_szó????". A helyes válaszokban zárójelben szereplő mondatok csak kiegészítik a választ, nem elvárás, hogy a zh-ban is leírjátok őket.

A megadott pontszámok a zh-ban szereplő pontszámok; elvileg a kérdések relatív nehézségén és fontosságán kívül azt is hivatottak tükrözni, mennyire részletes választ várok el. A későbbiekben a tapasztalatok alapján ezek a pontszámok módosulhatnak, és egy itt leírt négypontos kérdés legközelebb szerepelhet pl. hatpontosként.

Sajnos a zh-k helyesírása és magyarsága több esetben hagyott kívánnivalót maga után. Szerintem helytelenül írni igénytelenség. Ezzel persze nem kötelező egyetérteni, és a pontozásnál sem vettem figyelembe a nem értelemzavaró hibákat, de azért próbáljatok erre is odafigyelni.

Figyelem! A félreértések elkerülése végett: ennek az oldalnak az elolvasása, esetleg bemagolása nem pótolja a segédanyag többi részének elolvasását és megértését. Sajnálatos, hogy erre külön fel kell hívni a figyelmet.

Tartalomjegyzék |

[szerkesztés] 1 Unix-alapok

- Hogyan jut érvényre az, hogy egy felhasználó tagja egy csoportnak? Mi történik a felhasználó futó folyamataival, ha a felhasználó egy csoporttagságát megszüntetjük? (6 pont)

- Helyes válasz:

- Egy unixos felhasználónak van egy felhasználó-azonosítója (UID) és egy csoport-azonosítója (GID), vagyis egy csoportnak mindenképpen tagja. Ez az elsődleges csoporttagság. Emellett a felhasználó más csoportoknak is tagja lehet; a /etc/group fájlban (vagy az ezt helyettesítő címtárban/adatbázisban) fel van sorolva, hogy az egyes csoportoknak mely felhasználók a tagjai. Amikor a felhasználó belép, az őt beléptető processz a login shell elindítása előtt belép ezekbe a csoportokba is, és ezeket a csoporttagságokat a shell örökli tőle. Így tehát igazából a kiegészítő csoporttagságok halmaza a unixos processz egyik állapotváltozója, a GID pedig egy másik.

- Ha egy felhasználót kiveszünk egy csoportból, az a futó folyamatokat sehogyan sem érinti.

- Egy válasz a zh-ból (betű szerint):

- A felhasználó által birtokolt fájlok révén a fájlrendszerben (Unixban minden fájl) valamint a folyamatok állapotterében (GID, EGID mellett a supplementary - tehát nem elsődleges - csoport is megjelenik.

- Alapesetben a felhasználó saját UID-je és elsődleges csoportja ami az általa indított processzhez tartozik, de az effektív - tehát a jogosultságok vizsgálatához felhasznált - EUID/EGID lehet más (UID=0 vagy setuid, setgid bit pl.). Ehhez a felhasználóhoz képest nézi a rendszer, melyik supplementary csoportokba lépjen a processz (setgid/uid ????esetén????).

- Nem jut érvényre sehogyan sem, egy felhasználó futó folyamataiban ha megszüntetjük a csoporttagságot. Ellenbel egy rendszerhívással tudja maga a folyamat frissíteni ezeket (pl. mert kapott tőlünk egy jelzést, hogy tegyen így).

- Kommentár: A válasz 4 pontot ér; alapvetően jó, de sokmindent összekever, zavaros, részben érthetetlen. Mit jelent az, hogy "ehhez a felhasználóhoz képest nézi a rendszer, melyik supplementary groupokba lépjen a processz"? Setuidos bináris esetén csak az effektív UID állítódik át, a cél-UID supplementary groupjait nem kapja meg az új processz. (Nehéz is lenne megoldani, hiszen a csoporttagságok egy a kernelen kívüli adatbázisban vannak nyilvántartva, ami lehet akár relációs vagy LDAP is, ráadásul csoportnév szerint - a kernelnek a setuidos bináris futtatásakor valahogyan az adatbázisból kéne kinéznie, melyik usernév tartozik az adott uidhez, aztán pedig azt, hogy ez a user milyen csoportoknak tagja még.)

- Mit jelent a kiegészítő csoporttagság (supplementary group membership)? (4 pont)

- Helyes válasz:

- Egy unixos felhasználónak van egy felhasználó-azonosítója (UID) és egy csoport-azonosítója (GID), vagyis egy csoportnak mindenképpen tagja. Ez az elsődleges csoporttagság. Emellett a felhasználó más csoportoknak is tagja lehet; a /etc/group fájlban (vagy az ezt helyettesítő címtárban/adatbázisban) fel van sorolva, hogy az egyes csoportoknak mely felhasználók a tagjaik. Amikor a felhasználó belép, az őt beléptető processz a login shell elindítása előtt belép ezekbe a csoportokba is, és ezeket a csoporttagságokat a shell örökli tőle. Így tehát igazából a kiegészítő csoporttagságok halmaza a unixos processz egyik állapotváltozója.

- Ha egy processz tagja egy csoportnak, akkor vonatkoznak rá a fájlrendszerben a csoportra vonatkozó jogosultságbitek.

- Egy válasz a zh-ból (betű szerint):

- az amikor egy felhasználó a /etc/group fileban nem csak a saját group-jában szerepel, hanem egyibb csoportokban is pl: audio,floppy. Így több fájlhoz is hozzáférhet a filok nála groupra vonatkozó rwx csoportnál ezeket a csoport tagságokat is figyelembe veszi. csak a változtatás után indított process-ekre igaz, hiszen igazából nem a felh.nak, hanem a process-eknek van UID-jük és GID-jük.

- Kommentár: A válasz 2,5 pontot ér; több súlyos tévedést is tartalmaz, de ezekre szerencsére részben nem vonatkozott a kérdés.

- A /etc/group file-ban az egyes csoportok tagjai vannak felsorolva, nem az, hogy az egyes felhasználók mely csoportoknak tagjai (ha így lenne, az utolsó csoporttag törlésével elvesztenénk a csoportot is). A /etc/group amúgy csak a kiegészítő csoporttagságokat tartalmazza, a felhasználó a GID-jához tartozó csoportnál alapértelmezés szerint nincs felsorolva.

- Ha egy felhasználót berakunk egy új csoportba, akkor az általa indított új processzek nem kapják meg automatikusan az új csoporttagságot, hiszen a csoporttagságokat a szülőfolyamatuktól öröklik, az pedig nem rendelkezett ezzel a csoporttagsággal. Az új csoporttagságra új login session indításával vagy a newgrp segítségével lehet ténylegesen szert tenni.

[szerkesztés] 2 IP-alapok

- Hogyan működik a SYN támadás? (8 pont)

- Helyes válasz:

- A TCP SYN-elárasztás a TCP-kapcsolatfelépítés (handshake) egy sajátosságát használja ki. A kapcsolatot kezdeményező kliens először olyan csomagot küld a szervernek, amelyen a SYN bit be van állítva, egy kezdeti szekvenciaszámmal. A szerver erre egy SYNACK csomaggal válaszol, a saját szekvenciaszámával. Végül a kapcsolat létrejön, amint a kliens visszaküld egy olyan csomagot, amelyben csak az ACK bit van beállítva, és a szerver kezdeti szekvenciaszámát nyugtázza.

- Ahhoz azonban, hogy a szerver el tudja dönteni, hogy egy beérkező ACK üzenet egy kapcsolat-felépítés utolsó üzenete-e, meg kell jegyeznie, melyik kliensnek milyen kezdeti szekvenciaszámú SYNACK csomagot küldött. Ezek az adatok a TCP kapcsolatpuffer (TCP backlog-queue) nevű adatstruktúrában tároldónak, amelynek a mérete véges (gyakran portonként csak pár tucat félig nyitott kapcsolat tárolására elegendő).

- A SYN-elárasztás során a támadó rengeteg SYN csomagot küld, gyakran hamis IP-címről, ám egyik kapcsolat felépítését sem fejezi be ACK üzenettel, így a szerver puffere megtelik, nem képes új kapcsolatokat fogadni. A pufferben tárolt ún. félig nyitott kapcsolatok egy idő után, ha addig nem érkezik rájuk ACK, törlődnek; ám ha a támadó csomagok gyorsan jönnek, akkor elárasztják a tárolót, és az áldozat nem lesz képes a legtöbb legitim kliens kérésének feldolgozására.

- Egy válasz a zh-ból (betű szerint):

- A TCP-kapcsolat felépítésének normális menete a SYN - SYN ACK - ACK protokollfutam.

- Ezzel kétféleképp lehet visszaélni:

- a) Az ún 'SYN flood' támadás során a támadó nagymennyiségű SYN csomaggal árasztja el a célpontot (noha valódi kapcsolatfelépítési szándéka feltehetőleg nincs). Ez a célpontot beéníthatja, lefagyaszthatja, túlterhelheti (különösen az egyszerűbb hálózati eszközöket). DoS támadás.

- b) Egyszerű tűzfalak (amelyek nem állapotkövetőek, és csak a felépítést szolgáló csomagokra tartalmaznak szűrőfeltételeket) "becsaphatók", ha - nemlétező - sequence numberrel ellátott ACK csomagot küld a támadó.

- A syncookies ezeket a támadásokat hatékonyan képes elhárítani.

- Kommentár: a válasz 4 pontot ér. A kérdés az "a)" részben leírt támadásra vonatkozott, ennek az ismertetése azonban nem elég részletes; nem derül ki, mi okozza a túlterhelést, melyik erőforrás fogy el (hogyan különbözik egy SYN-elárasztás egy tetszőleges más csomagfajtával való elárasztástól?).

- A "b)" jelű támadásról nem derül ki, mitől "SYN támadás", és hogy mit nyer a támadó azzal, ha egy "nem létező" szekenciaszámú ACK csomaggal "becsapja a tűzfalat", de még az sem, mit jelent az, hogy egy szekvenciaszám nem létezik, vagy hogy az ACK csomag saját szekvenciaszámáról, vagy az általa nyugtázott szekvenciaszámról van szó.

- Akárhogy is, a syncookies mechanizmus csak az első ellen "véd" (a szó egy tág értelmében), a második ellen nem.

- Mire való a PMTU discovery és hogyan működik? (7 pont)

- Helyes válasz:

- L. az IP-alapok szócikkben; felesleges itt megismételni.

- Egy válasz a zh-ból (betű szerint):

- Path Maximum Transfer Unit Discovery: A maximális csomagmeret meghatározásár a szolgáló algoritmus, amely arra szolgál, hogy a kapcsolat kezdeményezője megállapítsa, hogy mekkora csomagokat küldhet az adott címzett felé.

- A kapcs. kezdeményező fél először egy előre beallított MTU meretű csomagot küld a címzettnek. Ezután a ????visszafelvő???? üzenetek (ICMP) alapján ????binalis???? kereséssel megkeressük az MTU-t. Ha a csomag átmegy, akkor megduplázzuk az előző méretet, ha viszont egy router "Fragmentation needed" üzenetet küld vissza, akkor az (MTUi+MTUi-1)/2-vel próbálkozunk és így tovább ????binalis???? kereséssel. Az IP elvi határa 64k az MTU-ra, de a különböző adatkapcsolati és fizikai rétegek általában 1-2MB (sic!) közötti értékeket engednek meg.

- Kommentár: A válasz a sok pontatlanság és egy darab, a Richter-skálán mérhető tévedés miatt csak 3 pontot ér.

- 1. A PMTU discovery egy TCP-kapcsolat mindkét viszonylatában lejátszható, nemcsak a kliens->szerver irányban.

- 2. A válasz nem tér ki a DF (Don't Fragment) bit szerepére.

- 3. A csomagméret megduplázása problémás lehet, hiszen ezzel a saját interfészünk MTU-jánál nagyobb csomagméret is előállhat.

- 4. Ha a saját interfészünk MTU-ja túl nagy, és ICMP fragmentation needed üzenetet kapunk, nincs í mínusz egyedik MTU, amit felhasználhatnánk, hiszen ez volt az első csomag - akkor viszont hogyan számítsuk ki a másodiknak a méretét?

- 5. Ha valahogyan eljutottunk a 800 byte-hoz (mondjuk a 400 duplázásával), és a 800 túl nagy, akkor a leírt algoritmus szerint először a 600-zal kellene próbálkoznunk, de ha az még átfér, akkor ezt duplázva, 1200-zal - az viszont több, mint 800, és már a 800 se fért át.

- 6. Az az 1-2MB nagyon sok lesz...

- Mire való az ARP? Milyen üzenetei vannak? (5 pont)

- Helyes válasz:

- Az ARP arra való, hogy az egy fizikai hálózaton levő IP-vel kommunikálni vágyó számítógépek fel tudják deríteni egymás fizikai rétegbeli címét. Etherneten és az Ethernetre elegendően hasonlító hálózatokban használják.

- Két üzenete van: a kérdés ("who-has 1.2.3.4 tell 1.2.3.1") és a válasz ("1.2.3.4 is-at 00:f0:0d:d0:0d:00").

- (Az ARP nem IP-csomag, így nincs IP-fejléce.)

- Adatkapcsolati szinten a kérdés forráscíme annak az állomásnak a címe, amely a választ tudni szeretné; a célcím a broadcast.

- A válasz forráscíme annak az állomásnak a címe, amely tudja a választ (ez nem feltétlenül a keresett állomás); a célcím a kérdező állomás címe.

- (Az ARP-kérdést elvileg nem muszáj broadcastként feltenni, de ez a leggyakoribb.)

- (Az ARP elvileg többféle Ethernet felett szállítható protokollt is támogat.)

- (Az ARP-kérdés a payloadban is tartalmazza a kérdező hardvercímét, és igazából erre a címre kell küldeni a választ.)

- (Elvileg a RARP-üzenetek is az ARP-hez tartoznak, de nemigen használ ilyet senki.)

- (A "who-has" és az "is-at" nevek a tcpdumphoz fűződnek, a szabvány kevésbé szemléletes neveken emlegeti az üzeneteket.)

- Egy válasz a zh-ból (betű szerint):

- ARP

- IP->MAC megfeleltetés

- who-has src mac: saját valós mac

- dst mac: FF:FF:FF:FF:FF:FF

- src IP: saját IP

- dst IP: a cél IP-je

- is-at src mac: cél saját mac-je

- dst mac: saját mac

- src IP: cél IP-je

- dst IP: saját IP

- Kommentár: a válasz 2,5 pontot ér. Súlyos hiba, hogy az ARP-t IP fölötti protokollként képzeli el. Nem írja le továbbá a who-has és az is-at üzenetek tartalmát.

[szerkesztés] 3 DNS

- Mekkora legyen egy rekord TTL-je? Miért éppen annyi? Miért baj, ha túl nagy, és miért baj, ha túl kicsi? (6 pont)

- Helyes válasz:

- Egy rekord TTL-je akkora legyen, hogy lehetőleg éppen a következő tervezett módosítás előtt járjon le. Ha nem tudjuk, mikor lesz a következő módosítás, akkor akkora legyen, amennyi ideig vállalható, hogy kliensek esetleg még a rekord régi tartalma szerint járnak el; tehát pl. az előző címén keresik a webszervert.

- Ökölszabály: várhatóan lassan változó rekordok TTL-je legyen néhány órás (vagy akár néhány napos). Nem valószínű, hogy gyakran változna pl. egy domain MX-ének a neve, tehát az MX rekord TTL-je akár egy hét is lehet; a névhez tartozó IP viszont talán megváltozhat "váratlanul" (pl. mert átmegyünk másik hosting-szolgáltatóhoz, vagy mert DNS alapú failovert valósítottunk meg), így ennek a TTL-je lehet jóval alacsonyabb (néhány óra, vagy failover esetén akár csak öt perc).

- Ha a TTL túl nagy, az azért baj, mert akkor a rekord tartalmának megváltoztatása után sokáig lehetnek olyan kliensek, akik a rekordnak még az előző tartalmát ismerik, és rossz gépnek próbálják kézbesíteni a leveleinket, rossz DNS-szervertől érdeklődnek a hosztneveinkről s.í.t. Ha az ebből adódó problémákat el akarjuk kerülni, akkor a rekord megváltoztatása után még legalább a TTL-ben megadott ideig mindkét címen (az újon és a régin) nyújtanunk kell a szolgáltatást.

- Ha a TTL túl kicsi, az azért baj, mert a kliensek csak rövid ideig cache-elik a rekordok tartalmát és feleslegesen gyakran fordulnak a DNS-szerverünkhöz; így a szervernek megnő a terhelése, a kliensek pedig lelassulhatnak (mert pl. két kattintás között megint le kell kérdezni a webszerver IP-címét).

- (Van olyan DNS-szerver, pl. a djbdns, amely tervezett DNS-változtatásokat úgy támogat, hogy a megváltoztatandó rekord TTL-jét minden válaszhoz egyenként kiszámítja úgy, hogy éppen a tervezett változtatás pillanatában járjon le.)

- Egy válasz a zh-ból (betű szerint):

- Általában néhány óra legyen egy DNS rekord TTL-je, ez szabja meg, hogy a kliens ezt meddit cachelheti. Ha túl nagy a TTL azzal az a baj, hogy lehet, hogy a rekord valami miatt megváltozott és erről csak nagyon későn a TTL lejárta után értesül a kliens. Ezért szolgáltatás kiesést okozhat.

- Ha túl kicsi azzal az a baj, hogy folyton lekérdezi a kliens ezzel megterheli a DNS szervereket. Ezért optimális a pár óra. Ha nagyobb karbantartást szeretnénk végezni, akkor ????érdemes???? a TTL-t ????1-re 1s-ra???? ????állítani????, megvárni míg a régi ????lejár???? majd ????utána???? elvégezni a karbantartást, ezzel gyakorlatilag 0 lesz a szolgáltatás kiesés.

- Kommentár: A válasz 4 pontot ér.

- Alapvetően jó, de nem írja le, hogy a néhány óra egy olyan ökölszabály, amitől bizonyos esetekben érdemes eltérni (l. a DNS-alapú failover, ill. a szinte biztosan hosszú életű rekordok esetét).

- Csak az ökölszabályt írja le, nem próbálja mérnöki módon megfogalmazni, mi alapján döntsük el, mennyi legyen a TTL.

- Nem említi, hogy a szolgáltatáskiesés elkerülhető, ha a régi címen is fenntartjuk a szolgáltatást a TTL lejártáig (ami persze költséges és/vagy lehetetlen lehet).

- Nem említi, hogy kliensoldalon is eredményezhet lassulást a túl kicsi TTL.

- Mi a baj a glueless delegációkkal? Ugyanakkor mi a jó bennük? (10 pont)

- Helyes válasz:

- Egy delegáció kétféleképpen lehet glueless. Az egyik eset az, amikor olyan szervernek delegálunk egy domaint, amelynek a nevére nem vagyunk autoritatívak (pl. mondjuk a .hu-ra autoritatív szerver az ns.foo.com-nak delegálja a foo.hu domaint). Ebben az esetben a delegáló szerver nem adhatja át glue-ként a delegációban szereplő szerver A rekordját a kliensnek, mivel nincs joga nyilatkozni arról a domainről, amelybe az a szerver tartozik; a .hu nameserver nem autoritatív a .com-ra (elvileg lehetne autoritatív arra is, de ez most mindegy).

- A másik eset az, amikor a delegáló szerver adatbázisába szándékosan nem vesszük fel az alárendelt szerver A rekordját annak ellenére, hogy megtehetnénk (mert autoritatívak vagyunk a nevére). Ez elég nagy marhaságnak tűnik; remélem, a valóságban senki nem csinál ilyet.

- A baj a glueless delegációval az, hogy a kliensnek újra kell kezdenie a feloldást, esetleg a gyökértől, hogy megtudja a megkérdezendő szerver IP-címét; ha közben újabb glueless delegációval találkozik, akkor megint, s.í.t. Így nem biztos, hogy adható felső korlát egy feloldás memóriaigényére. Ráadásul a glueless-ség körbeérhet, és ebben az esetben a körben szereplő egyetlen domain sem oldható fel.

- Pl. ha az a.com nameservere az ns.b.net, a b.net-é az ns.c.hu, a c.hu-é az ns.d.org, a d.org-é pedig az ns.a.com, akkor egyik domain sem elérhető, ha a delegációk glueless-ek, de mire ez kiderül, a rekurzív rezolver elpazarolt egy csomó időt és memóriát.

- A glueless delegáció egyetlen "előnye" az, hogy a delegációval kapcsolatos NS rekordot tartalmazó zónába nem kell felvenni a delegációt kapó DNS-szerver A rekordját, így ezt a rekordot karbantartani sem kell, ha megváltozna (ehhez persze viszonylag bonyolult üzleti folyamatok tartozhatnak, úgyhogy nem feltétlenül egyszerű). Ez roppant kényelmes a delegációt végző szerver üzemeltetője számára, csak mindenki mással kitolás.

- Hogy a mi domainjeinkre mutató delegációk gluelessek-e, azt mi magunk is befolyásolhatjuk; ha ügyelünk arra, hogy a domainre autoritatív szerver neve a domainen belül legyen (tehát a foo.com nameserverének neve a foo.com domainbe tartozzon, mondjuk ns.foo.com vagy a.ns.foo.com), akkor adunk esélyt a glue-nak.

- Egy válasz a zh-ból (betű szerint):

- A DNS-szerver a kérdezőnek delegáláskor a glue-ban átadhatja egy a keresett domainnel azonos zónába eső nameserver IP címét. Ez jó, mert így nem kell külön feloldani a nameserver ????nevét????, növekszik a DNS hatékonysága. Pl. a pool-foobar.axelero.hu megkérdezi a .hu zónáért felelős nameservert, hogy mi a www.bme.hu IP címe. A szerver válaszol, hogy ő nem authoritatív, de kérdezze meg az ns.bme.hu-t. Ilyenkor a kliensnek fel kellene oldani az ns.bme.hu-t is, ezt azonban a nameserver átadhatja glue-ban. Ha pl. a www.bme.edu-t próbáljuk meg feloldani, és a .hu-ért felelős name servertől kapjuk meg az ns.bme.edu IP címét, azt nem hisszük el neki.

- A glueless delegációk rontják a DNS hatékonyságát, jó bennük, hogy pl. minden további nélkül megváltoztathatjuk a name serverünk IP címért, mert mindig feloldásra kerül a neve. Ez az előny elenyésző, érdemes használni a glue-t.

- Kommentár: a válasz 9 pontot ér. Hibák:

- A .hu zónáért felelős szerver természetesen autoritatív minden, a .hu alatti névre, így a www.bme.hu-ra is. Nem azt válaszolja az erre vonatkozó kérdésre, hogy nem autoritatív (ilyen válasz a DNS-ben gyakorlatilag nem is lehetséges), hanem egy delegációt tartalmazó választ küld.

- Ha a .hu zónáért felelős szerver egy másik, .hu alatti szervernek delegál egy zónát, akkor annak a címét illik is átadnia glue-ban, hiszen kitől kérdezhetnénk meg, ha a .hu szerverek nem mondják meg?

- A válasz első fele részben redundáns volt; nem volt kérdés, mi a glue (de persze inkább írjatok többet, mint kevesebbet). Ugyanakkor ez a bevezető győzött meg arról, hogy a hallgató valószínűleg érti, miért rontja a glueless delegáció a DNS hatékonyságát, mert azt külön nem írta le.

- Mi a DNS poisoning, hogyan működik és hogyan lehet ellene védekezni? (12 pont)

- Helyes válasz:

- Legalább háromféle DNS poisoningot érdemes megkülönböztetni. Az egyik esetben a támadó az általunk megszólított nameserver helyett válaszol, és a válasz tartalmával mérgezi meg a cache-ünket (ezt akkor tudja könnyen megtenni, ha le tudja hallgatni a kérdést). Ezt a támadást DNS spoofingnak vagy DNS forgerynek (hamisításnak) is nevezik.

- A másik eset az, amikor a támadónak van egy domainje, mondjuk a foo.bar, és ennek valamelyik szubdomainjét delegálja - mondjuk - az ns.bme.hu-nak: ize.foo.bar. NS ns.bme.hu., és ehhez a válaszhoz glue-ként mellékeli az ns.bme.hu állítólagos IP-címét, de nem a valódit, hanem egy olyan címet, amit ő ellenőriz: ns.bme.hu. A 1.2.3.4 , ahol 1.2.3.4 a támadó szervere. Ha a kliensszoftver hibás, és elfogadja a glue-t annak ellenére, hogy a foo.bar nameserver nem autoritatív a bme.hu domainre (és így nincs joga nyilatkozni az ns.bme.hu IP-jéről), akkor a cache-ben a támadó által megadott - vélhetően jó hosszú - TTL lejártáig tárolja, hogy az ns.bme.hu IP-je 1.2.3.4. Ezután, ha ez a kliens olyan domainhez tartozó nevet próbálna feloldani, amire az ns.bme.hu autoritatív, az 1.2.3.4-hez fog fordulni, hiszen "tudja", hogy az ns.bme.hu IP-je ez. Így a támadó az ilyen módon "eltérített" szervernek szóló összes kérdésre adott választ ellenőrizheti, átírhatja.

- Ennek a támadásnak egy variánsa az, ha irreleváns Authority sectiont rak a támadó a válaszába, amiben pl. azt mondja, hogy bme.hu. NS ns.foo.bar., holott ezt nem is kérdezte senki.

- A harmadik fajta támadás lényege az, hogy a támadó man-in-the-middle támadást valósít meg egy primary és egy secondary nameserver között (vagy egyéb módon eléri, hogy a secondary őhozzá forduljon AXFR-rel a primary helyett), és az AXFR-rel átvitt adatokat "röptükben" átírja. Így a secondaryn a támadó által elhelyezett hamis adatok lesznek, úgyhogy azok a kliensek, akik a secondaryhoz fordulnak, a hamis válaszokat fogják megkapni. Ha a primaryt a támadó valahogyan ki tudja vonni a forgalomból, akkor minden kliens a hamis adatokat látja.

- Az első támadás ellen gyakorlatilag nem lehet védekezni (nem húzhatunk ki VPN-t a világ összes DNS-szerveréhez). A saját ellenőrzésünk alá tartozó szakaszon megnehezíthetjük a lehallgatást, de nagyjából ennyi. A lehallgatásra amúgy azért van szükség, mert minden DNS-kérés tartalmaz egy 16 bites azonosítót (amit amúgy nonce-nak hívnak), aminek a válaszban is szerepelnie kell; ha a támadó nem tudja, milyen nonce-szal ment ki a kérés, meg kell tippelnie, mit írjon a válaszba. Ha emellett a kérés forrásportja is véletlenszerű, összesen kb. 31-32 bitnyi véletlenséget (azért nem 32, mert jó pár forrásport kizárható) tudunk vinni a kérésbe, úgyhogy a vak tippelés nehézzé válik.

- A második támadás ellen úgy védekezhetünk, hogy nem fogadunk el olyan glue-t, amelyre az a szerver, amelytől kapjuk, nem autoritatív; a példában az ns.bme.hu IP-címét a gyökértől indulva külön meg kellett volna keresni a "hagyományos" feloldóalgoritmussal.

- Természetesen abban az esetben, ha a támadó szervere valóban autoritatív a .hu-ra vagy a .bme.hu-ra, azt hazudik az ns.bme.hu IP-jével kapcsolatban, amit csak akar; sőt, mivel ő mondja, definíció szerint az lesz az igazság. Ezért veszélyes, ha egy a DNS-hierarchiában "magas szinten álló" nameserverre betör valaki. Ez ellen max. úgy védekezhetünk, ha megpróbáljuk az összes választ az összes, rá autoritatív szervertől beszerezni, aztán pl. többségi szavazással eldöntjük, melyik választ fogadjuk el. Ez elég lassú lenne.

- A harmadik támadás ellen a saját szervereink esetében úgy védekezhetünk, hogy biztonságos VPN-t húzunk ki a két szerver között, és efölött AXFR-ezünk, vagy AXFR helyett valamilyen más, biztonságos, hitelesített átviteli módszert alkalmazunk (pl. rsync over ssh). Más szerveren így elhelyezett hamis adatok ellen gyakorlatilag nem tudunk védekezni (max. a többségi szavazásos módszerrel, de az nem hatékony és nem is 100%-os).

- Érdemes a Wikipédián utánaolvasni, ha nem lenne világos.

- (Ennyire részletesen nem kell leírni a válaszban.)

- Egy válasz a zh-ból (betű szerint):

- Ha egy támadó man-in-the-middle szerűen ???? be tud épülni egy kliens és egy DNS szerver közé, vagy két DNS szerver közé, akkor elcsípheti a DNS lekérdezéseket és meghamisíthatja a válaszokat.

- De ha például a támadó egy kiszemelt áldozatnál azt szeretné elérni, hogy a www.otp.hu címre az ő "phishing" oldala jöjjön be, akkor ezt sokszor beékelődés nélkül is megteheti, hiszen a DNS protokoll a kapcsolatnélküli UDP felett működik, tehát a támadónak csak folyamatosan, rövid időközönként "DNS Reply" válaszüzeneteket kell küldenie az áldozatnak, az eredeti DNS szerver nevében. Ezt UDP esetén egyszerűen megteheti, hiszen csak az IP fejléc source IP mezejét kell a DNS szerver IP-jére állítania, és a DNS üzenet tartalma pedig az, hogy a www.otp.hu IP címe a támadó szerverére mutat. Ilyenkor ha az áldozat egy DNS lekérdezést küld az otp.hu-ra és a támadó válaszcsomagja érkezik meg hamarabb, ????akkor???? ????máris???? sikeres volta "poisoning".

- Védekezési lehetőségek:

- * Minden lekérdezés tartalmaz egy nounce-ot, ami a válaszban is szerepel.

- * DNS protokoll TCP feletti használata

- * A DNS szerver hitelesíti magát, pl. PKI kiépítése esetén a válaszokban a kliens által küldött nounce a szerver titkos kulcsával le van titkosítva. (Nyilv. kulcsú digitális aláírás)

- Kommentár: a válasz 6 pontot ér.

- Nem tér ki a poisoning többféle módozatára, főleg a glue-alapú módszer leírása hiányzik.

- Nem magyarázza el, mi a nonce (nem nounce, de ez mindegy), és hogyan segít a védekezésben.

- Nem derül ki, miért jó a támadónak, ha két DNS-szerver közé épül be, mint man in the middle (talán az AXFR-es támadásra gondolt a hallgató, de nem írta le).

- Mit jelent a DNS-ben a "classless" delegáció? Mikor használnak classless ("de Groot") delegációt és miért? Mutasson példát classless delegációra! (10 pont)

- Helyes válasz:

- A reverse DNS (PTR rekordok rendszere) megalkotásakor A, B és C osztályú címekben gondolkodtak.

- A reverse DNS gyökere az in-addr.arpa. zóna; ennek a szubdomainjeit delegálják az egyes IP-tartományok üzemeltetőinek, hogy reverse DNS szolgáltatást tudjanak nyújtani. A DNS-ben a pont karakter választja el egymástól a hierarchia szintjeit; ha tehát pl. a 4.0.0.0/8-as hálózat teljes reverse-tartományát akarjuk delegálni egy nameservernek, akkor valami ilyesmit írhatunk az in-addr.arpa. zónafájljába: "4.in-addr.arpa. NS ns1.Level3.net.". Hasonlóképpen, ha a 152.66.0.0/16-os hálózat reverse delegációját nézzük, akkor egy "66.152.in-addr.arpa. NS ns.bme.hu." jellegű bejegyzést találunk majd a 152.in-addr.arpa. zónafájljában.

- Látható, hogy a reverse delegációnak ez a módja csak nyolccal osztható netmaskú alhálózatra működik; ha pl. a 172.16.0.0/12-höz tartozó reverse domaint akarnánk delegálni, gondban lennénk, mert a 16.172.in-addr.arpa túl szűk (a /12-es tartomány a 172.16.0.0-172.31.255.255 címeket foglalja magában), a 172.in-addr.arpa pedig túl tág.

- Kézenfekvő, hogy delegáljuk egyenként az összes reverse zónát 16.172.in-addr.arpától 31.172.in-addr.arpáig; ez 16 db NS rekord felvételét jelentené. A módszer kifogástalanul működik is, csak az a hátránya, hogy ha a delegációt fogadó, tehát a reverse zonáért ténylegesen felelős szerveren BIND, vagy egy BINDra hasonlítani vágyó program fut, akkor mind a 16 "önálló" domainhez külön zónafájlt kell létrehozni, és ezekre hivatkozni kell a konfigurációs fájlban. Ez nyilván olyan rettenetes megterhelést jelent, hogy mindenáron el kell kerülni; ezt a célt szolgálja a "classless" delegáció (amúgy érdemes elolvasni az RFC2317-et, akad benne marhaság a javából).

- (A BIND-felhasználók számára amúgy még rosszabb lenne a helyzet, ha pl. egy /25-ös hálózat reverse zónáját delegálná nekik valaki 128 darab NS rekorddal: 128 darab zónafájlt kellene létrehozniuk. Természetes, hogy egy szoftver tervezési hibáit egy új szabvánnyal kell maszkolni; ezért született meg az RFC2317. Nyilván a véletlen műve, hogy az RFC egyik szerzője az a Paul Vixie, aki a BIND-ot jegyző Internet Software Consortium munkatársa is. A sorok között ne olvassatok, oda nem írtam semmit! :)

- Példa. Tegyük fel, hogy az 1.2.3.4-es és az 1.2.3.5-ös IP-cím a miénk; a nameserverünk az ns.foo.com. Ez ugye az 1.2.3.4/31-es hálózat. "Classful" delegáció esetén két darab NS rekorddal intéznénk el a delegációt: "4.3.2.1.in-addr.arpa. NS ns.foo.com." ill. "5.3.2.1.in-addr.arpa. NS ns.foo.com." (sőt, még jobb lenne, ha nem glueless delegáció lenne, tehát mondjuk az ns.4.3.2.1.in-addr.arpa nevet viselné a nameserverünk). Classless delegáció esetén ugyanez úgy történik, hogy felveszünk egy darab NS-rekordot így: "4/31.3.2.1.in-addr.arpa. NS ns.foo.com." - ezzel létrehoztunk egy új zónát, a 4/31.3.2.1.in-addr.arpa nevűt; most már csak az a dolgunk, hogy az egyes PTR-rekordokat áthelyezzük ebbe a zónába, ezt pedig két CNAME rekorddal lehet megtenni: "4.3.2.1.in-addr.arpa. CNAME 4.4/31.3.2.1.in-addr.arpa." és "5.3.2.1.in-addr.arpa. CNAME 5.4/31.3.2.1.in-addr.arpa.".

- Így a DNS-kliens, amikor a 4.3.2.1 PTR rekordját keresi, megtalálja a 4.4/31.3.2.1.in-addr.arpára mutató CNAME-et, úgyhogy megpróbálja a 4.4/31.3.2.1.in-addr.arpa PTR rekordját feloldani, erre pedig a delegációt fogadó szerver a keresett PTR rekorddal válaszol. Egyszerű, nem?

- Note to self: Erre kéne részletes példa, mindkét szerver zónafájljával, a DNS-ről szóló oldalra. Bár az RFC-ben is megvan és DJB oldalán is.

- Egy válasz a zh-ból (betű szerint):

- Classless delegáció: ha egy DNS nem egy teljes A, B vagy C tartományt fed le.

- Delegáció: ha az adott DNS szerver "tudja" a választ, de a klienst továbbirányítja a megfelelő authoritatív szerverhez.

- Kommentár: a válasz sajnos csak 1 pontot ér. Csak a kérdés legegyszerűbb részére válaszolt ("mit jelent a classless delegáció?"), és arra is pontatlanul. Mit jelent az, hogy "egy DNS nem egy teljes A, B vagy C tartományt fed le"? Több DNS van? És pl. a BME nameserverei "nem fednek le" egy teljes A-osztályú hálózatot - akkor ez most classless delegáció? Ha igen, akkor ki delegál kinek mit classless módon? Ha nem, miért nem? Nyilván nem kellett volna ugyanolyan részletesen leírni, mint ahogy én leírtam feljebb, de annak ki kellett volna derülnie, hogy mi a "trükk" benne (a CNAME és a példában a 4/31.3.2.1.in-addr.arpa zóna).

- Mit jelent a DNS-ben a delegáció? Mondjon példát! (6 pont)

- Helyes válasz:

- Delegációnak - a kliens szemszögéből - azt nevezzük, amikor egy DNS-szerver válaszában nincs Answer section, csak olyan Authority section, amiben a kérdésben szereplő domainre, vagy egy a hierarchiában fölötte álló domainre vonatkozó NS rekordok vannak. Ebből a kliens megtudja, hogy melyik másik DNS-szervernek kell feltennie a kérdést a végső válasz reményében.

- A DNS-adminisztrátor szemszögéből a delegáció az, amikor szubdomaint definiál, és ennek a karbantartását rábízza valaki másra: a szubdomainhez tartozó NS-rekordban megadott szerver üzemeltetőjére.

- A DNS egésze szempontjából a delegáció az, ami hierarchikussá teszi a DNS-t, mint adatbázist. Elvileg a root szerverek minden névre autoritatívak, a valóságban azonban - a delegációnak köszönhetően - nem kell minden név összes rekordját ismerniük, hanem elegendő azt tudniuk, hogy a TLD-kre (top-level domainekre) mely szerverek autoritatívak; vagyis a TLD-ket delegálják azoknak a szervereknek, amelyek az egyes TLD-kre autoritatívak, s.í.t.

- Példa: Ha valamelyik, a hu. zónára autoritatív szervertől megkérdezzük, mi a www.bme.hu domain A rekordja (ne feledjük, a DNS-ben minden domain, a "hosztnevek" is), a válaszban nem lesz Answer section (vagyis a keresett A rekord), de lesz olyan Authority section, amiben fel vannak sorolva a bme.hu domainre autoritatív szerverek (és lehet egy Additional section, amelyben ezek közül azoknak, amik szintén .hu alattiak - vagyis, véletlenül, az összesnek - benne lesz az A és/vagy AAAA rekordja is - ez a glue).

- Példa az adminisztrátor szemszögéből: ha a hu. zónafájlba azt írjuk, hogy "bme.hu. NS ns.bme.hu.", akkor az ns.bme.hu-nak delegáltuk a bme.hu domainnel kapcsolatos kérdéseket.

- Egy válasz a zh-ból (betű szerint):

- Delegáció: ha csak azt mondjuk meg egy DNS-kérésre, hogy merre kell tovább tapogatózni a cím után.

- Pl. ha a www.bme.hu keresésekor a *.hu-ra autoritatív DNS szerver címét kapjuk válaszként

- Kommentár: a válasz 5 pontot ér. A delegációt, mint láttuk, többféle szemszögből meg lehet közelíteni; a hallgató a kliens oldaláról közelítette meg, és a lényeges információk többségét leírta. Hiányzik azonban, hogy kitől (ti. a root szervertől) fogjuk megkapni a .hu-ra autoritatív szerverek nevét (a címüket csak glue-ként). Ezek a pontatlanságok önmagukban nem súlyosak, de összesen indokolják egy pont levonását.

- Mit jelent a DNS-ben az NXDOMAIN? (5 pont)

- Helyes válasz:

- Ha egy kérdésre azt a választ kapjuk, hogy NXDOMAIN, az azt jelenti, hogy sem a keresett domainnek, sem egyetlen aldomainjének sem a keresett típusú, sem más típusú rekordja nincs. Csak olyan szerver jogosult NXDOMAINnel válaszolni, amely autoritatív a keresett domainre; ha egy szerver csak autoritatív kérdésekre válaszol, és olyan domainről kérdezik, amire nem autoritatív, akkor nem válaszolhat NXDOMAINt, hanem csöndben kell maradnia (mert a DNS-ben nincs olyan válasz, hogy "nem vagyok autoritatív").

- Egy válasz a zh-ból (betű szerint):

- A DNS szerver biztosan állítja, hogy sem a kérdezett domén, sem annak aldoméne nem létezik. Ez nem egyenértékű azzal, hogy a DNS szerver nem ismeri a domént vagy nem autoritatív rá.

- Kommentár: a válasz 4 pontot ér, mert nem fejti ki, mit jelent az, hogy egy domain "nem létezik" (ti. azt, hogy semmilyen típusú rekordja nincs), pedig igazából éppen ez volt a kérdés; az, hogy az NXDOMAIN a "domain" és a "(does) not exist" szavak valamilyen permutációjának rövidítése, elég evidens.

- Mit jelent az, hogy egy DNS-szerver autoritatív egy domainre? Mitől válik azzá? Ki határoz erről? (10 pont)

- Helyes válasz:

- Elsősorban azt jelenti, hogy a mindenki által ismert gyökérszerverektől elindulva az adott domainre vonatkozó kérdések feloldása során delegációs lánc vezet az adott DNS-szerverhez. Például az ns.bme.hu azért autoritatív a bme.hu domainre, mert azok a szerverek, amelyek a root szerverek szerint autoritatívak a .hu-ra, a .bme.hu-t (többek között) az ns.bme.hu-nak delegálják. Vagyis az autoritativitás "felülről érkezik", a DNS-hierarchiában "feljebb található" szerver nyilatkozata alapján válik egy "alacsonyabb szintű" szerver autoritatívvá egy domainre. Úgy is mondhatnánk, hogy a root szerverek a saját autoritativitásuk egyes partícióit adják tovább a delegációk mentén a TLD-kre autoritatív szervereknek, és így tovább. Egy domainre csak olyan szerver tehet minket autoritatívvá, amely maga is autoritatív rá (pl. a tmit.bme.hu-t csak a .bme.hu-ra, a .hu-ra vagy a gyökérzónára autoritatív szerver delegálhatja az alpha.tmit.bme.hu-nak, az ns.whitehouse.gov nem).

- Azt is fontos érteni, hogy a root szerverek minden domainre autoritatívak; a .hu szerverek (pl. az ns.nic.hu) minden, a .hu alatti domainre autoritatívak (tehát pl. az alpha.tmit.bme.hu vagy az ez.egy.nagyon.mely.domain.nev.hu IP-címéről is jogosultak nyilatkozni); a delegált domain nem kerül ki abból a halmazból, amelyre a szerver autoritatív. Tehát attól, hogy az ns.nic.hu az ns.bme.hu-t egy delegáció révén autoritatívvá teszi a .bme.hu-ra, még ő maga is autoritatív marad a .bme.hu domainre.

- Az autoritativitás másik kritériuma az, hogy a szerver saját magát autoritatívnak gondolja egy domainre; ez beállítás kérdése.

- A "ki határoz erről?" kérdésre a technikai válasz az, hogy a hierarchiában feljebb található domain karbantartója; jogilag természetesen ennél bonyolultabb a helyzet, de ez most nem érdekel minket.

- A "mit jelent?" kérdésre adott válaszhoz hozzá tartozik az is, hogy az adott szerver a saját adatbázisából képes megválaszolni minden, az adott domaint érintő kérdést (és ebből a szempontból a delegáció is válasznak számít); jogosult pl. úgy nyilatkozni, hogy a keresett név nem létezik (NXDOMAIN, l. feljebb).

- Egy válasz a zh-ból (betű szerint):

- Az autoritatív DNS-szerver azt jelenti, hogy az adott domainre vonatkozó név-IPcím megfeleltetésekért ő a "felelős": a kérések feloldásában az autoritatív DNS-szerver a hiteles válaszadó.

- A hierarchikus DNS-szervezésben alapvetően két fontos tényező tesz autoritatívvá egy DNS-szervert:

- a) "Gondolja magát annak" (Elvileg nem célszerű - nem szép dolog - olyan kéréseket kiszolgálni, amire nézve nem autoritatív a szerver)

- b) A hierarchiában felette álló szerverek delegálják az adott szervernek a vonatkozó domainre vonatkozó jogokat

- Kommentár: a válasz csak 8,5 pontot ér a következő két hiba miatt:

- 1. A DNS-ben nemcsak név-IPcím-párokat tárolunk, vannak más rekordtípusok is (-0,5 pont).

- 2. Dehogynem célszerű olyan kéréseket kiszolgálni, amire nézve nem autoritatív a szerver - éppen ezt csinálja a rekurzív rezolver, amit sok implementáció egybeépít az autoritatív szerverrel. Ami nem szép dolog, az az, ha úgy állítjuk be a szervert, hogy olyan domainre is autoritatívnak gondolja magát, amit nem delegálnak neki a felsőbb szintű szerverek. (-1 pont)

[szerkesztés] 4 Az SMTP működése

- Írja le egy tipikus SMTP-tranzakció menetét! Milyen üzeneteket küld a kliens, és milyeneket a szerver? (6 pont)

- Helyes válasz:

- Itt említeni kellett a HELO, a MAIL FROM, az RCPT TO, a DATA és a QUIT parancsot; röviden a levél felépítését (fejléc; üres sor; törzs; egyetlen pontból álló sor); és a szerver válaszainak felépítését (háromjegyű szám, az első jegy jelentése stb.). Bővebben l. Az SMTP működése c. szócikkben.

- Egy válasz a zh-ból (betű szerint):

- C->S: HELO valaki.valahol.hu.

- * ESMTP esetén HELO helyett EHLO

- * A kliens megadja a domain nevét

- S-C: HELO [...]

- A szerver köszönti a klienst, és megadja a paramétereit (név, típus, verzió, használható parancsok, stb...)

- C->S: MAIL FROM küldő@e-mail.címe.hu

- * A kliens megadja a küldő e-mail címét

- * Az "e-mail.címe.hu" jóesetben "valaki.valahol.hu"

- C->S: MAIL TO címzett@e-mail.címe.hu

- C->S: DATA [...]

- Itt küldi el a tényleges üzenetet.

- Az üzenet végét a ".<ENTER>" jelzi.

- S->C: Message received üzenet, ha minden rendben.

- Kommentár: a válasz csak 2 pontot ér, mert nem a valóságban használt SMTP-t, hanem egy hasonló, de alternatív protokollt ír le.